A/B-Testing

A/B-Testing ist eine datenbasierte Methode, bei der zwei Varianten eines Elements miteinander verglichen werden, um Conversion, UX und Marketing-Performance messbar zu verbessern.

Was ist A/B-Testing?

A/B-Testing beschreibt den kontrollierten Vergleich zweier Varianten eines Elements. Nutzer sehen zufällig Variante A oder Variante B. Anschließend wird anhand einer klaren Ziel-KPI (zum Beispiel Conversion-Rate) gemessen, welche Version bessere Ergebnisse liefert. So werden Entscheidungen nicht aus dem Bauch heraus getroffen, sondern anhand realer Daten.

Warum A/B-Testing im Marketing entscheidend ist

Daten statt Annahmen

A/B-Testing ersetzt subjektive Meinungen durch echtes Nutzerverhalten. Das reduziert Fehlentscheidungen, macht Optimierung planbar und schafft eine belastbare Basis für Skalierung.

Messbare Optimierung

Mit A/B-Testing lassen sich Conversion-Rate, Klickrate oder Formular-Abbruchrate gezielt verbessern. Optimierung wird nachvollziehbar, wiederholbar und lässt sich über Kampagnen hinweg konsistent ausrollen.

So läuft ein A/B-Test ab

Hypothese formulieren

Jede Änderung braucht eine klare Annahme, zum Beispiel: „Ein konkreter CTA erhöht die Klickrate“. Definiere außerdem eine Haupt-KPI, damit das Ergebnis eindeutig interpretierbar bleibt.

Varianten sauber ausspielen

Nutzer werden zufällig auf A und B verteilt. Wichtig ist, dass beide Varianten parallel laufen, damit externe Einflüsse (Wochentage, Traffic-Quellen, Kampagnen) den Vergleich nicht verzerren.

Auswertung und Rollout

Erst wenn genug Daten vorliegen, ist das Ergebnis belastbar. Der Gewinner wird ausgerollt, die Learnings dokumentiert und der nächste Test priorisiert.

Typische Einsatzbereiche von A/B-Testing

- Landingpages: Headline, Nutzenargumente, Trust-Elemente, CTA

- Formulare: Feldanzahl, Reihenfolge, Microcopy, Fehlertexte

- Onlineshop: Produktseiten, Preisanker, Warenkorb, Checkout

- Ads und E-Mail: Hooks, Betreffzeilen, Creatives, Zielseiten

FAQ zu A/B-Testing

Was kann man im A/B-Testing konkret testen?

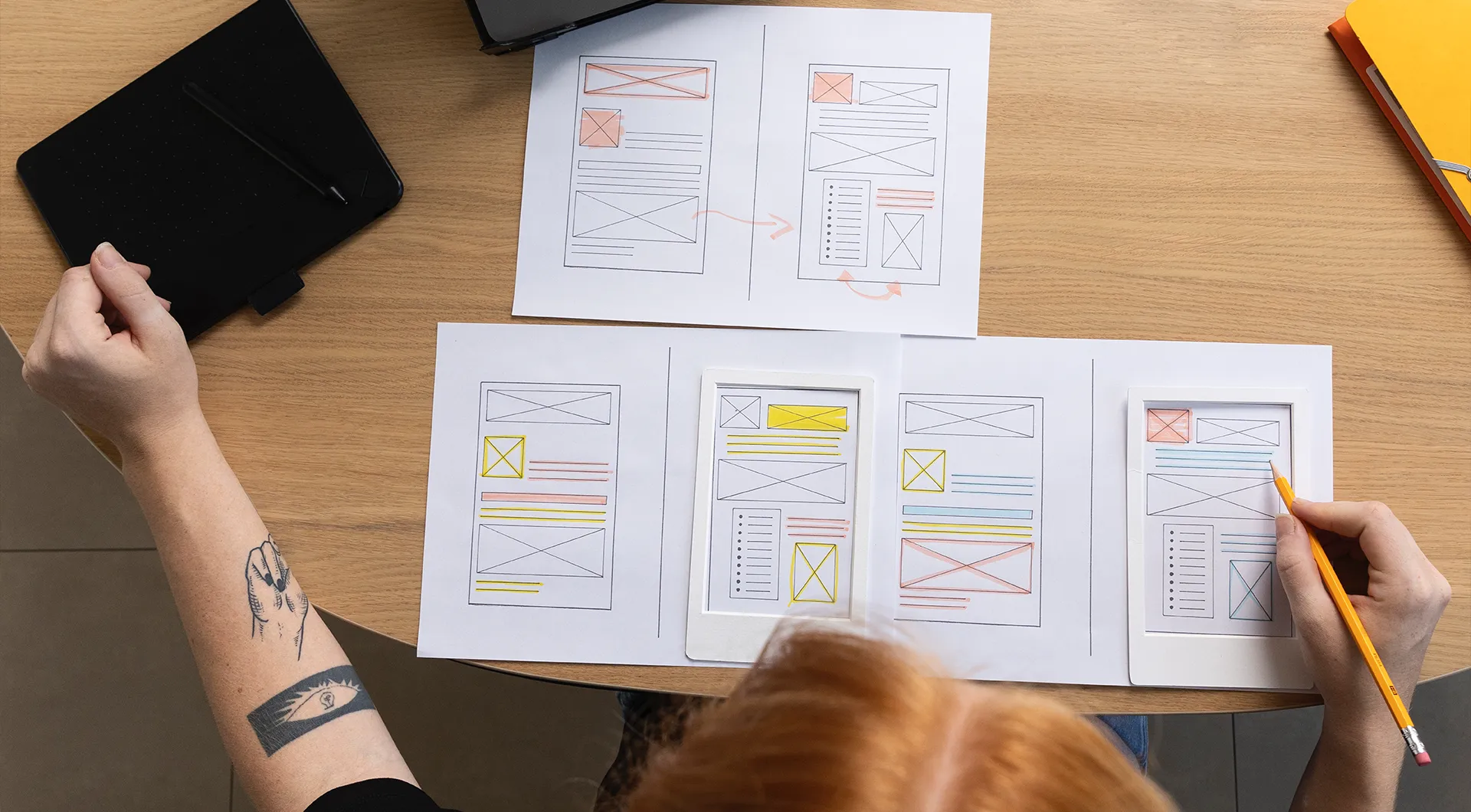

Häufige Testobjekte sind Headlines, CTA-Buttons, Angebotsdarstellung, Formulare, Trust-Elemente (Bewertungen, Siegel) und Layouts. Wichtig ist, pro Test eine zentrale Veränderung zu priorisieren, damit Ursache und Wirkung klar bleiben.

Wie lange sollte ein A/B-Test laufen?

Ein Test sollte so lange laufen, bis ausreichend Conversions für eine belastbare Aussage vorliegen. In der Praxis sind das oft mehrere Tage bis Wochen, abhängig von Traffic und Conversion-Volumen.

Welche KPIs sind beim A/B-Testing wichtig?

Die Haupt-KPI ist meist Conversion-Rate, Leads oder Käufe. Ergänzend helfen Micro-KPIs wie Klickrate, Scrolltiefe, Formular-Abbruchrate oder Add-to-Cart-Rate, um Reibung im Funnel sichtbar zu machen.

Was sind typische Fehler beim A/B-Testing?

Zu kurze Laufzeiten, mehrere große Änderungen gleichzeitig, fehlende Hypothese oder voreiliges Beenden sind die häufigsten Fehler. Das führt zu scheinbaren Gewinnern, die sich später nicht reproduzieren lassen.